本节主要介绍了信息熵的计算与感知机算法

信息熵

信息熵的计算:

交叉熵:用于表征两个变量概率分布P、Q(假设P表示真实分布、Q为模型预测的分布)的差异性

交叉熵越大,两个变量差异程度越大

交叉熵公式:

相对熵:是交叉熵与信息熵的差值

表示用分布Q模拟真实分布P,所需的额外信息

计算公式:

性质:

相对熵(KL散度)不具有对称性,即:

相对熵具有非负性

JS散度:具有对称性,现有两个分布$p1,p2$,其JS散度公式为:

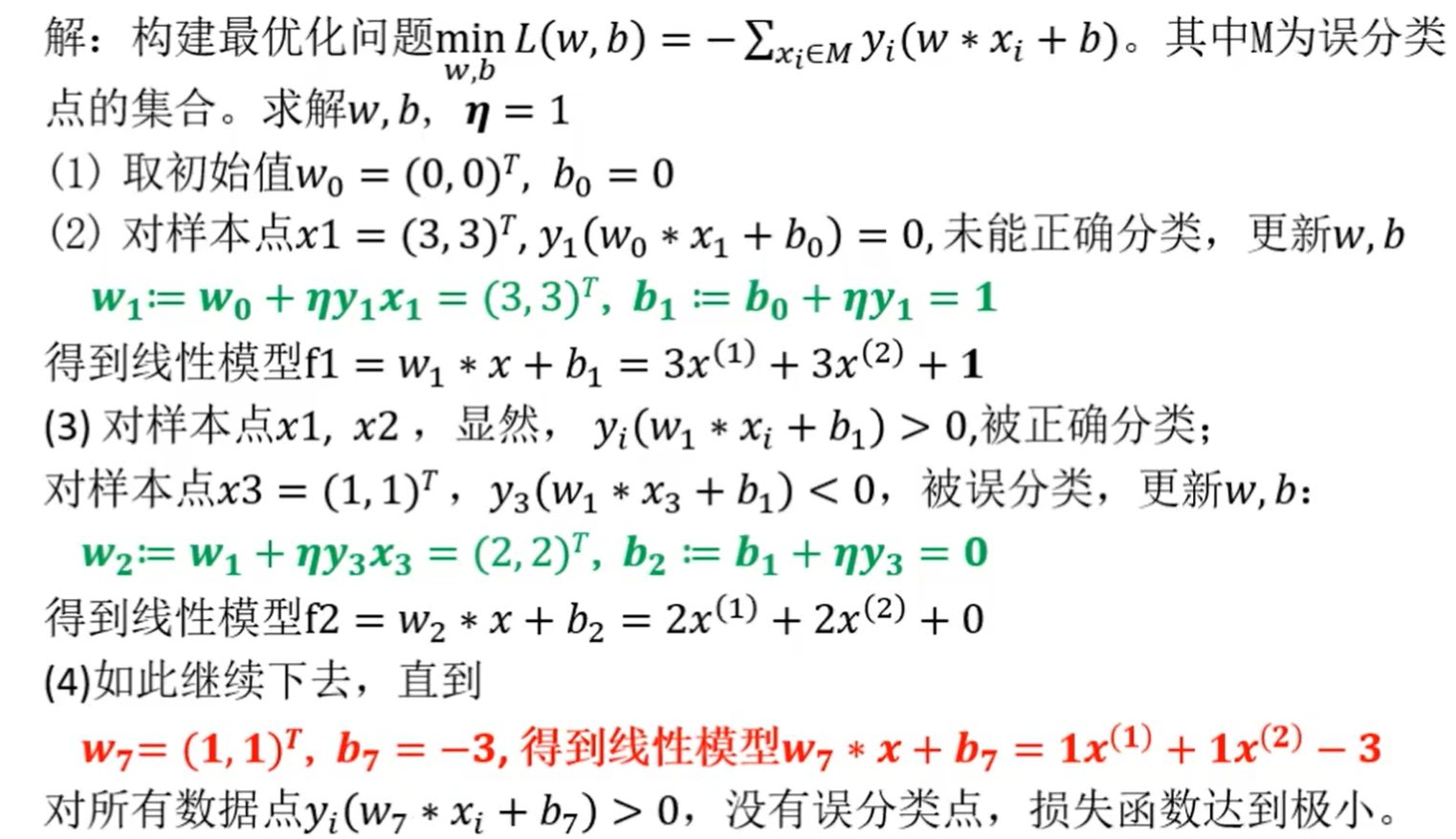

感知机

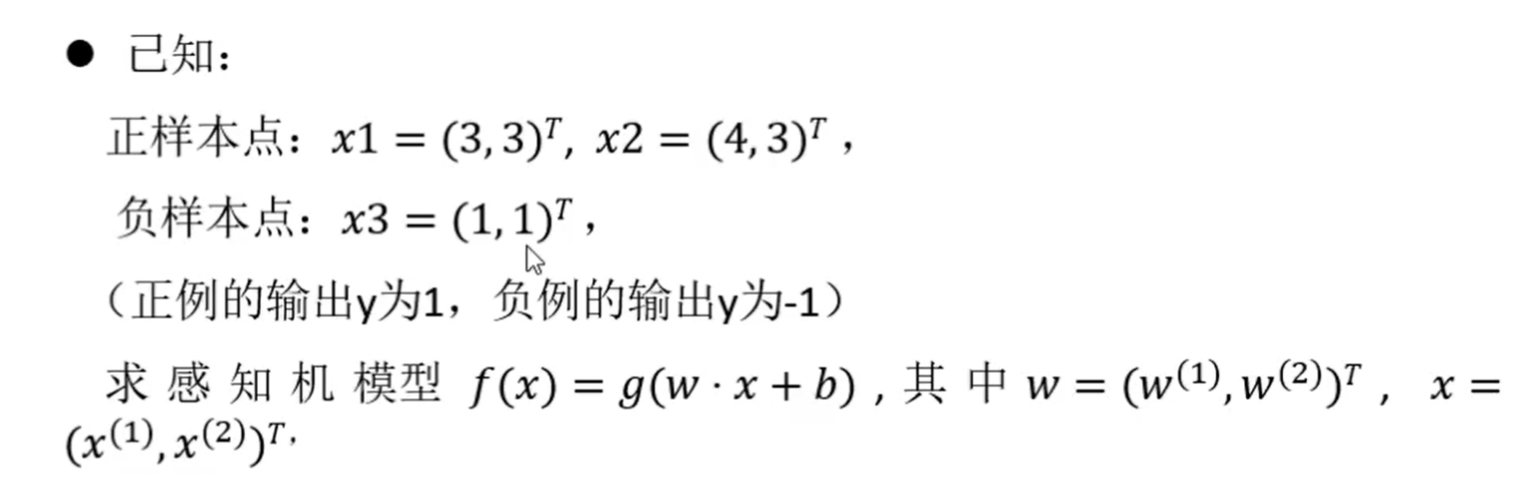

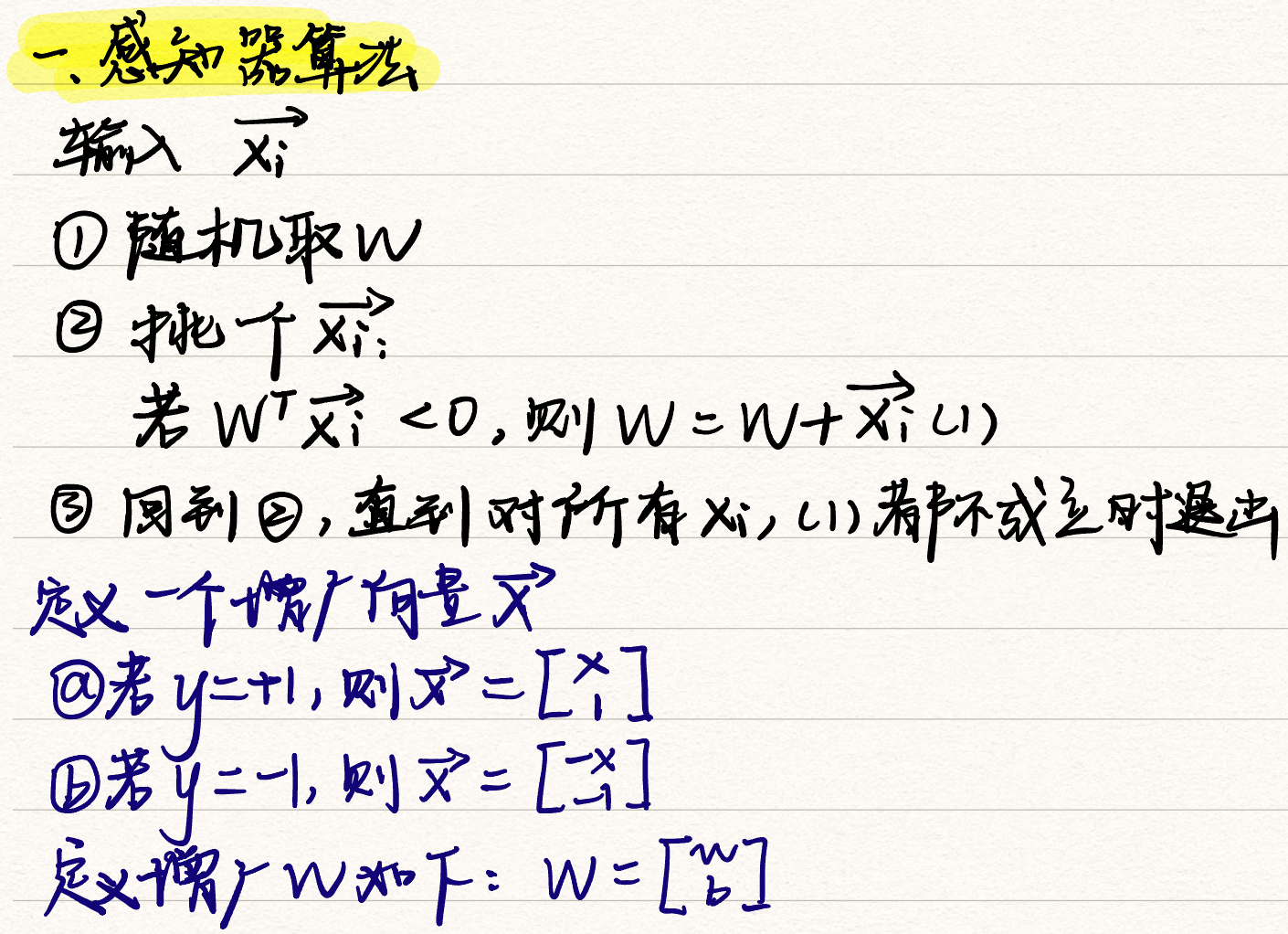

感知机是两类分类的线性分类模型,假设输入样本的特征向量x,输出实例样本的类别y,有:

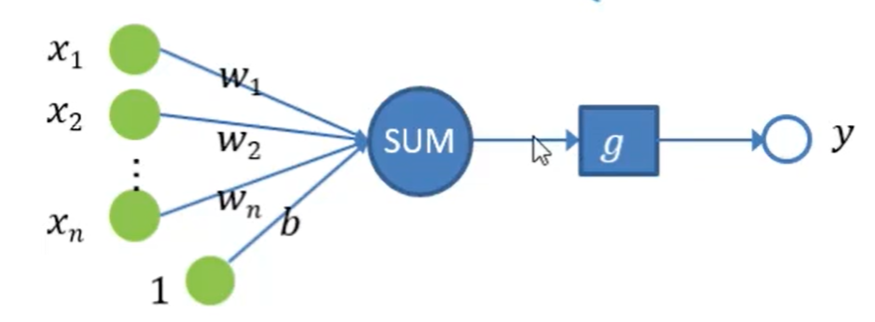

感知机的算法

例: